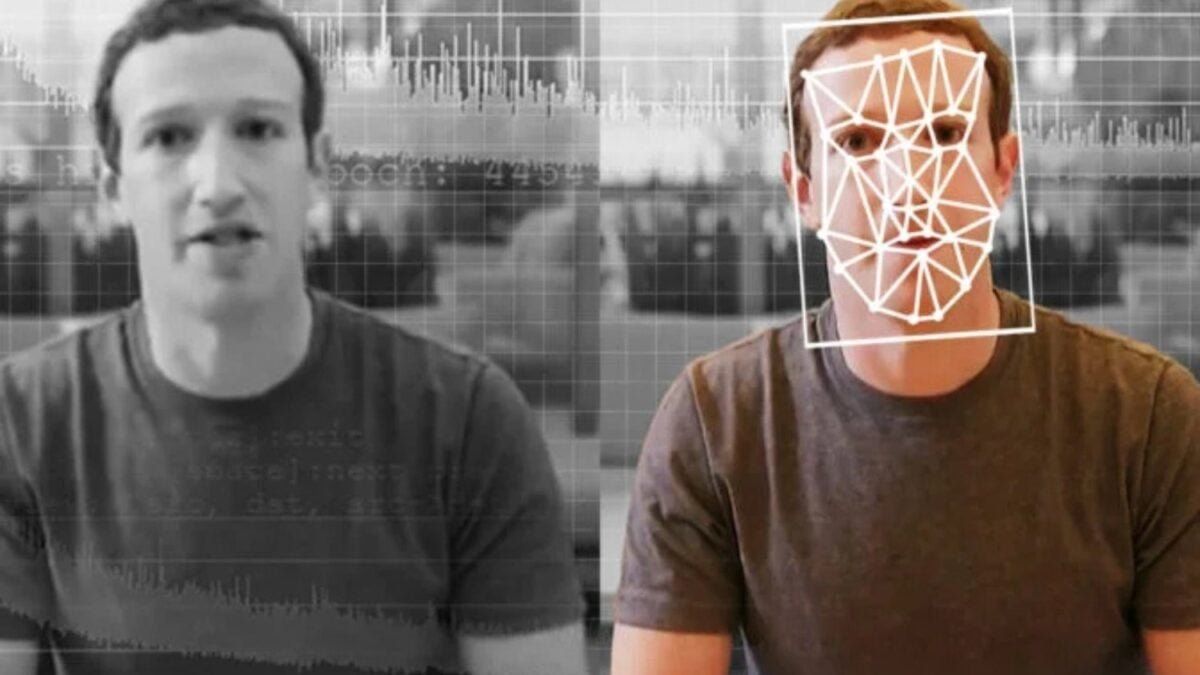

Los falsos vídeos, archivos de audio e imágenes han cruzado el límite de lo indistinguible. ¿Hacía dónde vamos ahora?

Fuente del artículo: The Conversation

A lo largo de 2025 los deepfakes mejoraron drásticamente. La calidad de los rostros, voces y cuerpos enteros generados por la IA imitando a personas reales mejoró más allá de lo que esperaban muchos expertos hace tan solo unos años. Y cada vez se usan más para engañar a la gente.

En muchas situaciones cotidianas – en especial videollamadas en baja resolución y lo que se comparte en las redes sociales – su realismo llega a engañar a los que no son expertos. Eso significa en la práctica que para la gente común lo sintético ya no puede distinguirse de lo auténtico. En algunos casos, también hay instituciones que caen en la trampa.

El ascenso no solo es en la calidad sino que el volumen de los deepfakes creció exponencialmente, y la firma de ciberseguridad DeepStrike calcula que de 500.000 falsos videos, imágenes o audios en Internet en 2023, la cifra trepó a unos 8 millones en 2025, con un crecimiento anual de casi el 900%.

Soy científico en computación e investigo los deepfakes y otros medios sintéticos. Desde mi punto de vista, considero que la situación probablemente empeore en 2026 a medida que los deepfakes aumenten su capacidad de reaccionar ante las personas en tiempo real.

Hoy casi cualquier persona puede hacer un video deepfake.

Mejoras drásticas

La escalada ha sido drástica gracias a varios cambios técnicos. Ante todo, el realismo de los videos mejoró mucho gracias a modelos de generación de video diseñados específicamente para mantener la consistencia temporal. Son modelos que producen videos con movimiento coherente, con identidad consistente con la de quien aparece en las imágenes, y contenido que de un cuadro al siguiente mantiene una línea de sentido. Los modelos bucean en la información relacionada con la representación de la identidad de la persona a partir de la información sobre el movimiento para que el mismo movimiento pueda mapearse para diferentes identidades o que una misma identidad pueda tener varios tipos de movimientos.

Los modelos además producen rostros estables, coherentes sin interrupciones o distorsiones en los ojos y la línea de la mandíbula, algo que antes servía como evidencia forense de que los videos eran falsos.

En segundo lugar, la clonación de voces logró cruzar el umbral de lo indistinguible. Hoy bastan unos pocos segundos de audio para generar un clon convincente, con la entonación natural, el ritmo, el énfasis, la emoción, las pausas y el ruido de la respiración. Es una capacidad que ya sirve para los fraudes a gran escala, y hay importantes tiendas que informan recibir más de 1.000 llamadas falsas generadas por IA cada día. Lo perceptual indica que las voces sintéticas que antes se detectaban fácilmente son cosa del pasado.

Lo tercero es que las herramientas de consumo casi han roto toda barrera técnica. Las actualizaciones de Sora 2 de OpenAI y Veo3 de Google y cantidad de startups significan que cualquier uno hoy puede describir una idea y hacer que un gran modelo de lenguaje como ChatGPT de OpenAI o Gemini de Google redacte un texto y genere un audiovisual bien pulido en tan solo minutos. Los agentes de IA pueden automatizar todo el proceso. Se ha democratizado efectivamente la capacidad de generar a gran escala videos falsos coherentes y con argumentos.

Es esa combinación de mejoras en la calidad y personajes casi indistinguibles de los humanos reales lo que crea grandes desafíos para detectar los deepfakes, en especial en el entorno de los medios donde la atención del usuario está fragmentada y el contenido avanza más rápido de lo que se requiere para verificarlo. Los daños y perjuicios en la vida real son también reales, desde la mala información al acoso dirigido y los fraudes económicos, todo a través de deepfakes que se comparten o viralizan antes de que las personas puedan darse cuenta de lo que está pasando.

El futuro es el tiempo real

Mirando hacia adelante, resulta clara la imagen del próximo año: los deepfakes avanzan hacia la síntesis en tiempo real que podrá producir videos que se asemejen en casi todo a los más finos detalles del aspecto de un humano, con lo que será más fácil que evadan a los sistemas de detección. Se está corriendo la frontera del realismo visual estático hacia la coherencia temporal y conductual, con modelos que generan contenido en vivo o casi en vivo, en lugar de clips hechos de antemano.

Los modelos de identidad convergen hacia los sistemas unificados que no solo captan el aspecto de la persona sino su forma de moverse, de hablar, y cómo suena en distintos contextos. El resultado ya no será “se parece a tal persona”, sino “se conduce como tal persona en el tiempo”. Creo que se podrán sintetizar en tiempo real todos los participantes de las videollamadas, actores impulsados por la IA, interactivos y con rostros, voces y gestos que se adaptan al instante con solo ingresar una consigna. Los estafadores podrán usar avatares que respondan, en lugar de videos predeterminados.

A medida que maduren estas capacidades, seguirá borrándose el límite entre los medios humanos auténticos y los sintéticos. La línea de defensa se correrá y ya no servirá el criterio humano. Más bien, todo dependerá de las protecciones a nivel de la infraestructura, como la proveniencia asegurada por firmas criptográficas, y herramientas de contenido de IA que utilicen las especificaciones de la Coalición por la Proveniencia y Autenticidad del Contenido. También dependerá de herramientas forenses multimodo como el Deepfake-o-Meter de mi laboratorio.

Ya no servirá simplemente mirar los píxeles con atención.

Siwei Lyu, Profesor de ciencias e ingeniería de la computación; Director de UB Media Forensic Lab, University at Buffalo

Artículo republicado desde The Conversation bajo licencia Creative Commons. Disponible aquí el artículo original.

Este artículo ha sido traducido de Gizmodo US por Romina Fabbretti. Aquí podrás encontrar la versión original.