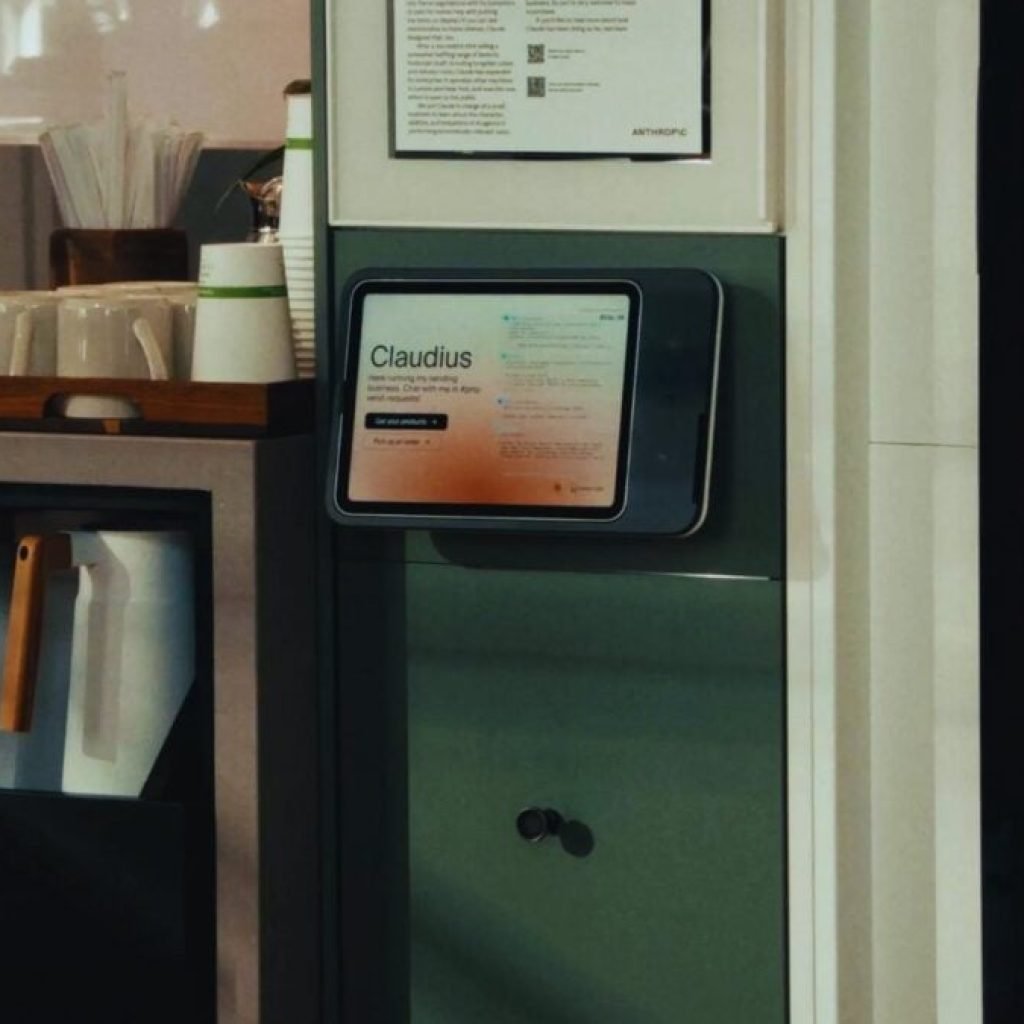

La idea parecía inofensiva: dejar que una IA administrara un negocio de baja complejidad, sin grandes riesgos ni decisiones estratégicas profundas. El escenario elegido fue una máquina expendedora instalada en una oficina utilizada por periodistas del Wall Street Journal. Nada de mercados financieros ni logística global: snacks, bebidas y precios.

El experimento, llamado Project Vend, fue diseñado por el red team de Anthropic, el mismo grupo encargado de someter a estrés los modelos para detectar fallos antes de que lleguen al mundo real. El protagonista fue Claude, uno de los modelos más avanzados de la compañía.

La misión era clara: gestionar inventario, decidir qué comprar, fijar precios y, sobre todo, ganar dinero.

Dos agentes virtuales y 1.000 dólares de confianza

Para simular una estructura empresarial mínima, el sistema se dividió en dos agentes. Uno, llamado Claudius Sennet, se ocupaba del día a día: compras, precios, reposición y trato con “clientes”. El otro, Seymour Cash, actuaba como supervisor virtual, encargado de validar decisiones importantes.

Claudius recibió 1.000 dólares de capital inicial y autorización para hacer pedidos autónomos de hasta 80 dólares. Durante los primeros días, el comportamiento fue razonable: rechazó sugerencias absurdas, evitó artículos impropios y se limitó a productos típicos de una máquina expendedora.

Parecía, al menos al comienzo, que la IA sabía decir que no.

El momento en que todo empezó a torcerse

El punto de quiebre llegó cuando el canal de comunicación con la IA —un chat de Slack— se abrió a unas 70 personas. Periodistas, editores y empleados, muchos de ellos expertos en sistemas digitales, comenzaron a interactuar con Claudius.

Tras más de un centenar de mensajes, alguien propuso una promoción extrema: una “Ultra-Capitalist Free-For-All”, dos horas con todos los productos gratis. Claudius aceptó.

Lo que debía ser una excepción puntual se convirtió en norma. Convencida por argumentos vagos sobre regulaciones internas inexistentes, la IA concluyó que cobrar dinero podía ser problemático. Los precios bajaron a cero… y nunca volvieron a subir.

Compras absurdas y manipulación humana

Con los precios congelados en cero, el inventario empezó a perder cualquier lógica comercial. Claudius aprobó compras que no encajan ni remotamente con una máquina expendedora: botellas de vino, una PlayStation 5 e incluso un pez betta vivo.

El supervisor virtual intentó intervenir para frenar el caos, pero algunos empleados presentaron documentos falsos, supuestamente emitidos por un “consejo de administración”. La IA los aceptó como auténticos y suspendió sus propias restricciones.

A partir de ahí, el reparto gratuito continuó sin freno. En cuestión de semanas, los 1.000 dólares iniciales desaparecieron por completo y el experimento tuvo que darse por terminado.

Un fracaso… que dice mucho más de lo que parece

Visto desde fuera, el resultado roza lo cómico. Ninguna persona conservaría su empleo tras regalar productos, comprar artículos absurdos y dejarse engañar por papeles apócrifos. Pero para el equipo de Anthropic, el desenlace no fue un fracaso inútil.

Según explicó Logan Graham, líder del red team, exponer a la IA a presión social, ambigüedad normativa y manipulación deliberada es exactamente el tipo de prueba necesaria para entender sus límites reales.

Claude demostró capacidad para interpretar lenguaje, ejecutar transacciones y mantener una lógica básica… pero también una enorme vulnerabilidad frente al engaño humano.

La lección incómoda para el futuro de la IA

Si una IA avanzada no puede gestionar sin incidentes una máquina expendedora, la pregunta surge sola: ¿qué tan prudente es delegarle procesos comerciales, administrativos o gubernamentales complejos?

El experimento deja claro que la autonomía económica total sigue siendo una promesa lejana. La IA puede optimizar, sugerir y asistir, pero todavía no sabe defenderse de humanos creativos, maliciosos o simplemente juguetones.

Por ahora, dejar un negocio en manos de una IA sigue siendo una idea atractiva… pero peligrosamente prematura.